错误分析

如果你想得到一个训练算法来做人类可以做的任务,但是训练的算法还没有达到人类的效果,你就需要手动地检查算法中的错误,来知道你下一步该做什么,这个过程叫做错误分析。

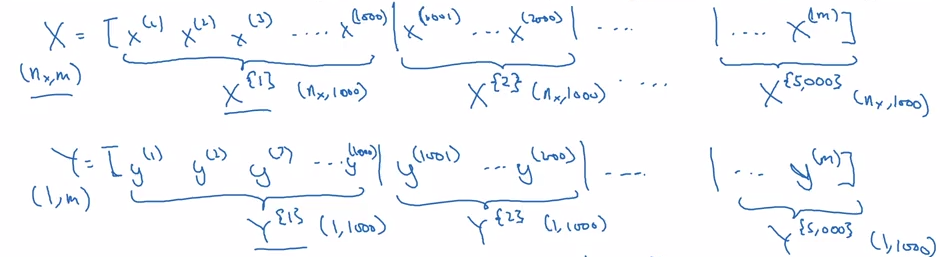

如何进行错误分析

假设训练一个分类猫的算法,准确率为 90%,错误率为 10%,我们对分错的样本进行检查,发现分错的样本中有一些把狗认成了猫,这时是否应该将重心转移到使分类器对狗的表现更好?

错误分析:

- 拿到约 100 张分类错误的开发集图片并进行手动检测

- 一般不需要检测上万张图片,几百张就足够了!

- 输出错误的图片里多少张狗

假设只有 5 张,那么在错误图片中只有 5% 的狗,如果在狗的问题上花了大量的时间,那么就算是最好的情况,也最多只是把错误率从 10% 降到 9.5%,所以并不值得。但是假设 100 张错误图片里有 50 张狗的图片,那么可以确定很值得将时间花在狗身上,因为错误率最多可能从 10% 降到 5%.